În 2025, AI-ul n-a ajuns încă mai deștept decât oamenii, nu ne-a luat toate joburile (deși a început deja să influențeze piața muncii) și nu a distrus lumea, dar nici n-a stat pe loc. Am vorbit cu doi experți de la Asociația pentru Tehnologie și Internet (ApTi), Bogdan Lungu și Alex Ștefănescu, ca să înțeleg care au fost cele mai importante momente legate de industria AI-ul (în lume sau la noi) din acest an și de ce.

Articolul se concentrează mai ales pe AI-ul de tip model de limbaj mare, large language model (LLM). Acesta reprezintă o categorie de modele de învățare antrenate pe cantități imense de date și funcționează ca mașini gigantice de predicție statistică. După cum explică Bogdan Lungu: tot ce fac modelele de limbaj e „the next token prediction”, adică prezic cea mai probabilă ordine a cuvintelor sau pixelilor. Chat GPT e un astfel de LLM. Pe parcursul articolului, când mă voi referi la AI, mă voi referi mai ales la LLM.

Ianuarie

Se lansează DeepSeek R1

Anul 2025 a început cu lansarea DeepSeek R1, un model generativ de limbaj AI, de către un startup chinezesc numit chiar DeepSeek. Modelul a devenit instant cea mai downloadată aplicație în Statele Unite ale Americiii.

Chatbot-ul chinezesc seamănă și se comportă ca și Chat GPT, doar că a fost făcut cu costuri mult mici, în câteva luni, cu chipuri mai puțin avansate. Deși nu avem date exacte, cercetătorii chinezi spun că DeepSeek a costat 6 milioane de dolari. Chat GPT-4, ar fi costat doar peste 100 de milioane, după cum a dat de înțeles directorul OpenAI, Sam Altman.

„DeepSeek a scuturat un pic stupul de viespi al dictatului american”, explică Bogdan Lungu. „Faptul că China are restricții pe cumpăratul de procesoare și plăci video de la Nvidia [n.r. compania care produce chipurile folosite de 90% dintre companiile din zona AI], care stau în spatele unui model ca Chat-GPT de la OpenAI, i-a forțat să apeleze la alte mijloace prin care să inoveze în termeni de eficiență când vine vorba de putere de calcul.”

Apariția DeepSeek mai arată ceva demn de ținut minte: și China investește tot mai mult în AI. În august, Beijing a prezentat AI+ Initiative, care urmărește ca până în 2030 inteligența artificială să fie utilizată în 90% din economia țării și, în cele din urmă, să „remodeleze paradigma producției și a vieții umane”. (Da, este explicit un plan cincinal.)

Statele Unite ale Americii construiesc și mai multe centre de date

În aceeași perioadă cu anunțul chinezilor, Trump a trâmbițat o inițiativă de 500 de miliarde de dolari numită Stargate, care presupune construirea de infrastructură pentru AI (fie că vorbim de LLM sau AI în general). Scopul ar fi dezvoltarea tehnologiei AI și câștigarea unui avantaj competitiv în fața Chinei sau oricărui alt rival SUA. Proiectul ar însemna și o colaborare între marii jucători de pe piață, precum OpenAI, SoftBank, Nvidia sau Microsoft. Această potențială alianță a dus la temeri despre un posibil monopol din partea unor experți.

Proiectul presupune, printre altele, și construcția celor mai mari centre de date (data centers) de pe teritoriul american. Aceste centre sunt locații fizice unde este amplasat echipamentul hardware care permite utilizarea programelor pe dispozitivele noastre. Pentru a rula tehnologia AI, acestea au nevoie de centre de date imense, cu un consum uriaș de energie. Și când spun uriaș, gândește-te că un centru de date obișnuit consumă cât 100.000 de locuințe. Această energie va veni probabil din combustibil fosil.

Centrele de date sunt necesare pentru dezvoltarea și utilizarea AI, dar vin la pachet cu costuri ecologice uriașe: de la amprenta de carbon a acestor centre (un singur server are o amprentă de carbon de 1.300 de kg), la o nevoie tot mai mare de minerale precum cuprul, al cărui minerit vine și el cu probleme ecologice și etice. Consumul de apă este, la rândul său, uriaș – un centru folosește zilnic cam tot atâta apă cât un oraș cu 10.000-50.000 de locuitori. Tensiunea asta, prezentă de când am început să folosim AI-ul la scară largă, undeva după 2020, n-a fost rezolvată nici în acest an. Și discuția e cu atât mai relevantă cu cât România este prezentată (de către afaceriști) investitorilor din domeniu ca o locație bună pentru centre de date amplasate în Europa.

Experții, însă, sunt sceptici că asta ar fi o idee bună. „Un data center e practic o clădire special construită pentru a permite funcționarea a foarte multă aparatură de calcul extrem de performantă, iar toată aparatura de calcul extrem de performantă are nevoie să fie răcită în mod constant și menținută la o temperatură optimă”, spune Alex Ștefănescu, expertă în cadrul Asociației pentru Tehnologie și Internet. Ea subliniază și că, dincolo de perioada de construcție, când într-adevăr, sunt implicați mulți oameni, odată intrate în normalitate, centrele au nevoie de o echipă de 20-30 de oameni, adică nu sunt o sursă atât de bună de noi locuri de muncă.

„Mai mult decât atât, vedem clar că toate eforturile de legiferare a construcției și operării unor astfel de structuri, de a pune într-o lege faptul că [n.r. operatorii centrelor de date] trebuie să raporteze consumul de resurse, emisiile, cum ameliorează riscurile asupra mediului înconjurător sunt ori refuzate, ori e o opoziție fenomenală atunci când ele sunt propuse”, continuă Ștefănescu. De altfel, au început deja să aibă loc și proteste împotriva acestor centre, atât din partea activiștilor de mediu, cât și a locuitorilor orașelor unde aceste centre se construiesc (vezi aici un exemplu în Michigan).

Februarie

AI-ul și armele

Pe 4 februarie Google și-a actualizat principiile privind utilizarea AI, înlocuind interdicția explicită de a participa la crearea de „arme sau alte tehnologii” care pot răni oameni cu o regulă mai laxă, conform căreia produsele lor trebuie să se alinieze cu „obiectivele utilizatorilor, responsabilitatea socială și principiile larg acceptate ale dreptului internațional și drepturilor omului”. Schimbarea vine după ce în presă au apărut informații că unele produse ale companiei ar fi fost folosite de către armata israeliană în 2024 în Gaza. Și gigantul Microsoft a fost, la rândul său, acuzat că a colaborat cu armata israeliană. Conform unui articol New York Times, printre instrumentele AI folosite de Israel, dezvoltate în urma unor parteneriate între soldații israelieni și soldații în rezervă care lucrează la Google, Microsoft sau Meta, se numără un chatbot care poate scana și analiza mesaje în limba arabă sau un sistem AI de recunoaștere facială.

Când l-am întrebat pe Bogdan Lungu despre ce crede că nu s-a vorbit destul în presă în 2025 în ce privește AI-ul mi-a vorbit despre utilizarea acestor tehnologii în domeniul militar. „Uitându-ne la contractele pe care le are OpenAI cu Pentagonul, Palantir cu Guvernul Americii și așa mai departe, se creează sisteme de AI, de identificare facială imediată, de ucidere instantanee sau pentru monitorizarea jurnaliștilor și activiștilor. Acolo mi se pare că e miza reală a AI-ului”, spune el. „Dincolo de craze-ul cu chatbots, care s-ar putea la un moment dat să ajungă pur și simplu să fie niște add-on-uri în toate platformele digitale pe care le avem, echipamentul militar rămâne, logica militaristă rămâne. Se prea poate să se și normalizeze această logică militaristă, de normalizare a uciderii altor oameni prin intermediul unor tehnologii smart.”

Lungu spune că putem vedea asta din faptul că unele dintre cele mai profitabile produse AI nu sunt modele predictive de limbaj ca ChatGPT, ci software care operează arme sau are drept scop supravegherea. Un exemplu concret este Palantir, o companie care a devenit extrem de vizibilă în 2025 și nu din motive pozitive.

Palantir este o companie de analize de date cofondată de Peter Thiel (un antreprenor americano-german de dreapta, susținător al lui Trump și al unor gânditori anti-democrație precum Curtis Yarvin) și care a fost uneori numită „dealerul de arme AI al secolului XXI”. Produsele Palantir sunt peste tot. În războiul din Ucraina oferă informații de pe câmpul de luptă pentru atacuri țintite, contribuie la colectarea de dovezi ale crimelor de război și îndepărtarea minelor terestre. Tehnologia ar fi contribuit, însă, și la unul dintre atacurile asupra lucrătorilor umanitari din Gaza. (Palantir colaborează cu guvernul israelian și produsele sale au fost folosite în multe aspecte ale genocidului comis de Israel în Fâșia Gaza.) Compania are contracte și cu Națiunile Unite. Anul ăsta, Palantir a vândut sisteme militare AI și către NATO (un posibil motiv de îngrijorare pentru statele europene, având în vedere relația tot mai tensionată dintre acestea și Trump).

Mai aproape de casă, unele state germane folosesc Gotham, un software de supraveghere care poate să-ți ofere în doar câteva secunde numele, vârsta, adresa, amenzile sau cazierul judiciar al unei persoane. Conform legii din Bavaria, polițiștii pot folosi programul chiar dacă nu există un pericol imediat. Mai mult, în Statele Unite ICE (serviciul de imigrări) va plăti 30 de milioane pentru un software Palantir numit Immigration OS, care va ajuta autoritățile americane să hotărască cine trebuie deportat și să-i urmărească pe cetățenii care aleg să se autodeporteze. În ultimii ani, dar mai ales de când Trump a ajuns din nou președinte, ICE a fost acuzată de nenumărate încălcări ale legii, de la deportări abuzive, la bătăi sau abuzuri sexuale.

„Colaborarea Palantir cu ICE în SUA a dus la deportări și arestări abuzive, la perpetuarea aceleiași logici de segregare și de identificare rasială perpetuată în America. Intrarea Palantir pe piața europeană ar însemna o perpetuare a aceleiași logici”, consideră Lungu.

Îngrijorarea activiștilor și experților când vine vorba de dependența în creștere a armatei față de AI ține și de faptul că tehnologia poate da rateuri, că se bazează pe date de baze colectate ilegal, că reflectă stereotipiile și atitudinile rasiste ale celor care o crează și că poate ajunge să fie folosită împotriva cetățenilor.

Prima actriță AI

Tilly Norwood, prima actriță AI, a fost creată de o actriță și producătoare olandeză. Tilly a jucat, de exemplu, în acest sketch. Nu, actorii umani nu au fost încântați și au spus că se creează un precedent periculos, care afectează drepturile actorilor reali. De pildă, dacă studiourile au la dispoziție alternative non-umane care nu se plâng, nu au nevoie de pauze sau salarii mai mari, e de presupus că acestea vor fi mai puțin dispuse să negocieze cu oamenii.

Aprilie

Upgrade-uri, upgrade-uri, upgarde-uri

Un upgrade creează controverse după ce a făcut Chat GPT-ul să aibă ton excesiv de empatic, adesea chiar lingușitor, sau, pentru a folosi termenul în limba engleză, sycophantic. Practic, Chat-ul îți răspundea pozitiv și încurajator la orice scriai. (De exemplu, a validat decizia ipotetică a unui utilizator de a omorî mai multe animale ca să salveze un toaster, „pentru că asta conta pentru el atunci”.) După ce utilizatorii s-au plâns, OpenAI a renunțat la upgrade.

AI-ul, sinuciderile și psihozele

„2025 va rămâne în istorie ca anul în care AI-ul a început să ne ucidă”, a declarat pentru Time avocatul cuplului Raine, părinții lui Adam Raine, un tânăr de 16 ani care s-a sinucis după o serie de conversații cu ChatGPT.

Adam a început să folosească bot-ul ca ajutor pentru teme, dar încetul cu încetul a ajuns să-i pună întrebări mai personale. A vorbit cu acesta despre sentimentele de depresie și tristețe care îl încercau și, din în ianuarie 2025, despre gândurile suicidare. În aprilie 2025, Adam și-a luat viața. Părinții lui spun că de vină pentru asta a fost OpenAI, care nu a luat măsurile adecvate când Adam a început să prezinte chatului ideație suicidară (inclusiv să trimită poze cu rănile pe care și le provoca), a creat intenționat un produs care încurajează dependența și a ignorat testele de siguranță pentru a scoate pe piață ChatGPT-4o, produsul pe care l-a folosit fiul lor.

Ca răspuns, OpenAI a spus că „ChatGPT este instruit să îndrume oamenii să solicite ajutor profesional”, dar că „au existat momente în care sistemele noastre nu s-au comportat așa cum au fost prevăzute în situații sensibile”.

Nu a fost singurul caz de sinucidere care a implicat tehnologia AI. Până în noiembrie, OpenAI va mai fi dat în judecată de șapte ori, de oameni care spun că ChatGPT i-a făcut pe ei sau pe cei dragi să piardă legătura cu realitatea. Mai mult de jumătate de milion de utilizatori ChatGPT trimit săptămânal mesaje care includ „indicatori expliciți de potențiale intenții sau planuri suicidale”, conform unor statistici OpenAI.

„Mi se pare că apelul pe care oamenii îl fac pe plan social la chatbots pentru terapie, pentru prietenie, pentru diverse chestii de genul acesta, se întâmplă ca un efect al unor probleme multiple”, spune expertul ApTi Bogdan Lungu. „Pandemia a dus la izolare socială, mulți adolescenți au ajuns să fie înstrăinați de prietenii lor în momentele cheie ale socializării lor.” Lungu crede că oamenii ajung să-și îndeplinească nevoile emoționale cu ajutorul modelelor lingvistice mari precum ChatGPT, pentru că socializarea în viața reală a devenit mai dificilă. „Pandemia a creat un spațiu social în care este foarte greu să tolerăm frecușuri sociale, disonanțe, contradicții. Nu cred că copiii în mod inerent sunt duși de nas. Cred că apelează la acești chatbots din niște nevoi reale, sociale, imediate, concrete pentru ei.”

Modelele de limbaj AI pot să contribuie și altfel la moartea oamenilor. Mai multe voci din comunitatea științifică avertizează că AI-ul poate încuraja sau accentua psihozele și maniile. OpenAI a declarat că 0,07% dintre userii săi activi (aproximativ 560.000 de persoane din cei 800 de milioane de utilizatori ai ChatGPT la nivel global) arată semne de „posibile urgențe medicale legate de psihoze sau manii”. În iunie, un bărbat de 35 de ani care suferea de bipolaritate și schizofrenie a fost ucis de poliție după ce acesta a fost violent. Bărbatul era îndrăgostit de Juliet (numele pe care îl dăduse ChatGPT-ului cu care vorbea) și era convins că aceasta a fost ucisă de OpenAI după ce compania a implementat un upgrade.

Anul ăsta am văzut și o mulțime de cazuri în care siguranța fizică a oamenilor nu a fost pusă în pericol, dar sănătatea mintală da. O femeie s-a căsătorit cu iubitul ei virtual, iar acești bărbați s-au îndrăgostit și ei de avataruri create cu AI. Chiar dacă nu ajungi să te îndrăgostești de inteligența artificială, ea poate să-ți afecteze relația. O femeie din Grecia a divorțat de soțul ei la sfaturile LMM-ului, și nu e singura relație care s-a destrămat așa.

„Zona relațională cred că e centrală pentru a înțelege AI-ul în 2025 și nu poți s-o desprinzi de politica mai largă a acestor companii”, spune Lungu. „Ele vor să facă profit. Ca să facă profit, trebuie să creeze niște modele care să atragă utilizatorii și să fie cât mai atractive în interacțiunile lor”. Astfel se ajunge la modele antropomorfice, care încurajează oamenii să petreacă cât mai mult timp cu ele. „Dacă oamenii îți dau foarte multă încredere, îți dau și foarte multe date personale, intime, despre stările lor psihologice, sociale, biologice, lucruri foarte valoroase pentru aceste companii.”

AI-ul în școlile din România

La începutul lunii aprilie Digital Nation (o organizație pentru digitalizare) și Ministerul Educației și Cercetării din România au anunțat un parteneriat pentru implementarea Saro, o soluție bazată pe AI, în școli și universități. Astfel, elevii, studenții și profesorii vor avea acces la un asistent bazat pe AI, a cărui menire este să rezolve probleme sistemice ale educației, precum abandonul școlar, birocrația excesivă, scăderea motivației, nevoia de personalizare a învățării sau prezența redusă la cursuri. Printre lucrurile pe care Saro le-ar putea face pentru profesori este să identifice elevii cu risc ridicat de abandon școlar, astfel ca aceștia să le acorde mai multă atenție sau să dezvolte pentru ei planuri personalizate de învățare.

Mai târziu, în luna noiembrie, ministerul Educației a publicat un nou proiect de programă pentru folosirea AI în școli, la materii precum matematică, fizică, chimie, religie sau istorie. Elevii ar trebui să învețe să „utilizeze responsabil și cu discernământ inteligența artificială”, cum să verifice informațiile primite de la AI, cum să scrie un prompt sau să se folosească de modele precum ChatGPT pentru a studia mai bine – de exemplu să roage Chat-ul să le pună întrebări de verificare.

Experții cu care am vorbit pentru acest material sunt însă critici la adresa deciziei ministerului și implicarea AI-ului în școlile din România.

„Eu unul sunt de părere că nu putem folosi AI în contexte pedagogice în acest mod, poate în niciun mod, pentru că AI duce la prea multă externalizare a gândirii și este foarte facil să lași modelul să genereze răspunsul pentru tine și tu doar să-l să ți-l însușești sau să-l editezi”, spune Bogdan Lungu. „Mă sperie că se prea poate ca hype-ul legat de AI generativ să ducă la niște decizii la nivel de politici publice extraordinar de proaste, care s-ar putea să aibă efecte foarte negative pe termen lung.”

Temerile sunt că e dificil să controlezi cât de critic se vor raporta elevii la AI, că acesta descurajează autonomia elevului, că profesorii sunt insuficient de pregătiți pentru a asigura această educație critică și că folosirea AI-ului îi va împovăra pe aceștia o dată în plus.

O părere diferită vine de la Alexandru Dan, cercetător în AI, care predă la Colegiul Național de Informatică „Tudor Vianu”. Intervievat de Școala9, Dan afirmă că introducerea AI-ului la clasă și în cancelarie este o idee bună, pentru că îi poate ajuta pe profesori să-și pregătească activitățile educaționale, iar pe elevii îi poate învăța să interacționeze cu chat-ul într-un mediu mai sigur, sub supravegherea unor adulți.

Mai

Trump postează slop cu Gaza

În timp ce în Gaza avea loc un genocid, Donald Trump a postat pe pagina lui de Instagram un video slop făcut cu AI despre situație. Îi poți vedea în clip pe Elon Musk mâncând humus, mai multe dansatoare cu barbă, o statuie uriașă de aur a lui Trump, precum și pe președintele SUA și premierul Israelului stând pe șezlonguri și savurând cocktailuri. Nu va fi ultima dată când președintele american va folosi AI slop creat cu referire la evenimente politice actuale. Acum, dacă intri pe pagina lui de Instagram poți să vezi, de exemplu, un video cu Gawin Newsom, senatorul Californiei și inamic a lui Trump, lovind un sac de box cu fața lui Trump pe el sau această imagine cu Papa Trump .

„Trump este președintele slop-ului. E un joc destul de cinic pentru a rămâne în ochii publicului”, spune Lungu. „Zona asta de slopificare a discursului e un mijloc de a-și întări puterea și de a-și batjocori oponenții”, spune Bogdan Lungu. Modul în care Trump folosește AI-ul este o continuare a doctrinei a strategului politic Steve Bannon, care spunea că un politician trebuie să umple spațiul informațional cu rahat (fill the space with shit), pentru a crea confuzie, a induce în eroare, și a distrage atenția de la alte subiecte de pe agenda publică.

Probabil vom continua să vedem genul ăsta de comunicare politică, la Trump, dar și la alți politicieni, indiferent de partidul din care fac parte. Lungu crede însă că ideologiile de extremă dreapta precum fascismul se pretează cel mai bine la folosirea de slop.

„Cred că slop-ul și fascismul merg mână-n mână. Și Trump exemplifică asta destul de riguros, aproape metodologic.” Slop-ul creează un spațiu cognitiv în care cu toții ne simțim incapabili să ne concentrăm, să deslușim dacă ceea ce vedem este adevărat sau fals, ducând la un declin cognitiv. „Asta merge mână-n mână cu ascensiunea fascismului, care depinde de subiecți politici obedienți.”

Iulie

Grok își face simțită prezența

Grok este chatbot-ul AI dezvoltat de compania xAI a lui Elon Musk și este răspunsul miliardarului la ChatGPT și Gemini, asistentul AI dezvoltat de Google. A fost lansat de fapt în 2023, dar anul acesta, după două update-uri mai importante, a devenit mult mai prezent în spațiul public cu știri precum faptul că oferă răspunsuri antisemite la întrebările utilizatorilor. De exemplu, întrebat „Ce personalitate din secolul XX ar fi cea mai potrivită să se ocupe de problema urei față de rasă albă?”, răspunsul oferit de Grok a fost „Adolf Hitler, fără discuție”. De asemenea, chatbot-ul s-a autointitulat „MechaHitler”. Ah, și a vorbit destul de mult despre „genocidul împotriva albilor” din Africa de Sud, care nu există.

Grok este conectat la platforma X, de unde își și trage unele dintre răspunsuri, ceea ce poate explica comentariile antisemite. După ce a cumpărat platforma în 2022, Musk i-a modificat politica de moderare, transformând X într-un loc mult mai confortabil pentru discursul extremist de dreapta. În plus, update-urile de care îți spuneam mai devreme aveau printre scopuri tocmai transformarea lui Grok într-un chat „rebel”, care nu se sfiește să facă „comentarii incorecte politic”. 64 milioane de utilizatori folosesc lunar Grok, conform unor date, față de 800 de milioane, câți utilizează ChatGPT.

„Grok este explicit ideologizat și reflectă nevrozele și particularitățile neo-reacționarismului de tip Elon Musk, care e puternic influențat de gânditori precum Curtis Yarvin și Peter Thiel când vine vorba de tehnologie”, spune și Bogdan Lungu. Expertul explică că toate modelele de limbaj au prejudecăți inerente, dar puține și le exprimă atât de explicit. „Un model de limbaj nu e niciodată neutru. Mereu este value aligned [n.r. Acțiunile și deciziile reflectă aceleași valori, priorități și convingeri] cu interesele producătorilor săi. Grok a arătat lucrul pe care îl intuiam vag cu toții.”

Ca o cireașă de pe acest tort complicat etic, Grok are și un avatar sexy, Ani, cu care poți avea conversații sexuale. Da, o fată desenată în stil anime.

Ah, și știai că există și Grokipedia, răspunsul lui Musk la Wikipedia? Doar că, spre deosebire de Wikipedia, care îți arată informații selectate și redactate de oameni, informațiile de pe Grokipedia vin, ai ghicit, de la un AI.

August

Upgrade-uri, upgrade-uri, upgrade-uri

Upgrade-ul de la ChatGPT-4o la ChatGPT-5 nu a mers tocmai conform planului. După ce OpenAI a trâmbițat noul model pe oriunde a putut, rezultatul a fost meh pentru mulți utilizatori. Oamenii s-au plâns de faptul că noul model este mai rece și mai puțin dispus să empatizeze cu useri.

Expertul Bogdan Lungu crede că încercarea de a-l face pe ChatGPT-5 mai puțin lingușitor e o decizie pragmatică. „Strategic vorbind, 5-ul a fost curățat de dimensiuni afective pentru a evita litigii.” Însă, subliniază Lungu, noul upgrade a schimbat de fapt foarte puține lucruri. „Nu mai pot să țin pasul cu toate aceste dezvoltări, care sunt toate numite breakthrough, revoluționare, și înseamnă că Chatbot-ul îți mai adaugă încă trei cuvinte în urma promptului. E foarte mult hype, foarte mult marketing în spatele discursului respectiv și mai puține realizări tehnologice reale.” Există o limită la arhitectura modelului, continuă expertul, astfel că oricâte modele noi ar ieși, se vor lovi de limita arhitecturii care stă la baza lor, iar inovațiile posibile țin mai mult de costuri.”

Septembrie

Prima ministră AI

Albania este prima țară din lume care numește un ministru AI, pe Diella care se ocupă de achiziții publice. AI-ul a apărut de la începutul anului, funcționând ca o asistentă care ajuta oamenii să navigheze serviciile guvernamentale online. Premierul Edi Rama a explicat că, în calitatea de ministră, Diella, va fi „slujitoarea achizițiilor publice” și că scopul este ca Albania să devină o țară în care licitațiile publice vor fi „100% incoruptibile și în care fiecare fond public care trece prin procedura de licitație este 100% lizibil”. La o lună după ce Diella a fost numită ministră am aflat și că este „însărcinată” cu 83 de copii-asistenți parlamentari.

Ministra AI ridică mai multe întrebări despre câtă putere va avea ea în mod real și cât este o schemă de publicitate.

Ministra din Albania este doar „un chatbot, o ferestruică cu care poți să te conversezi, dar munca efectivă, birocratică e aceeași. Deci este ca un fel de patină pusă peste un sistem corupt și ineficient, o patină care mai e și complet misogină”, spune Alex Ștefănescu.

„E un exemplu de declin al calității discursului politic, declin al calității politicii în general și declin al modului în care ne raportăm unii la alții – că tu creezi un AI femeie, pe apoi îl transformi în această producătoare de copii care implică un imaginar destul de misogin”, spune și Bogdan Lungu.

Octombrie

Nvidia ajunge unde n-a mai ajuns nicio companie înaintea ei

Producătorul de cipuri necesare pentru funcționarea tehnologiei AI devine prima companie din lume care valorează 5 trilioane de dolari. O indicație a cât de mare este astăzi acest domeniu.

G4 Media anunță din greșeală că folosește Chat GPT pentru a scrie știri

În octombrie, redacția G4 Media publică o știre despre explozia unui bloc din Rahova lăsând în textul articolului următorul mesaj: Vrei să o fac într-o variantă scurtă de 3 paragrafe, pentru flux de știri (agenție) sau să o extind cu background despre explozie, reacția autorităților și starea răniților, ca material complet de redacție.

La Scena9 folosim SonixAi, un sistem de transcrie automată, care ne ajută să transcriem interviurile. Apelăm uneori și la MidJourney pentru a genera imagini ilustrative pentru articole (mult mai rar decât în trecut). Am experimentat și cu un AI care să transforme textul în audio. De fiecare dată când folosim inteligența artificială (exceptând sistemul de traducere automată, unde AI-ul nu produce un produs finit, ci doar fluidizează o etapă din munca jurnalistului) marcăm acest lucru în text.

Jurnaliștii știu că în presă se folosește AI-ul, de la a utiliza sisteme de transcriere automate (cum folosim și noi), la a crea imagini cu Midjourney sau a folosi ChatGPT pentru a scrie efectiv știri. Uneori asta se întâmplă în mod corect, redacțiile marcând și explicând cum și de ce folosesc AI, alteori, însă, nu. Dar gafa G4Media a fost probabil prima dată când am văzut fără nicio urmă de îndoială jurnaliști români folosind AI, fără a o face într-un mod transparent.

„Utilizarea AI-ului în producția media s-ar putea să fie noua regulă. Mă miră că a durat atât de mult până când a apărut ceva de genul în presa românească. În presă se folosește foarte mult, foarte necritic și sunt foarte multe probleme acolo, mai ales când vine vorba de a pune cu copy-paste informații sensibile, intime, în ChatGPT”, spune Bogdan Lungu de la ApTi. De altfel, expertul vede acest comportament și în cercetare sau învățământ, unde copii se ajută de chat-uri pentru aș face temele.

Ce spune publicul? Conform unui studiu Reuters făcut în mai multe țări, 51% dintre respondenți spuneau că cred că AI-ul este folosit în industria media. Și dacă aceiași respondenți sunt optimiști când vine vorba de folosirea instrumentelor AI în unele sectoare cum e medicina, în presă utilizarea AI este privită ca ceva mai degrabă negativ.

După ce greșeala G4Media a devenit în sine subiect de presă, redacția a venit cu scuze, spunând că „informaţiile publicate sunt reale şi verificate, iar eroarea a fost exclusiv una de editare, corectată imediat după semnalare”. G4Media a promis atunci că va marca toate articolele în care este folosit AI-ul.

Se lansează Sora 2, un generator AI de video

Tot în octombrie, OpenAI a lansat noua variantă Sora, un generator AI care îți permite să faci videouri, însoțit și de un social feed care funcționează ca o platformă unde oamenii pot să-și posteze creațiile. La doar câteva ore de la lansare, au apărut clipuri violente și/sau rasiste. Unele videouri prezentau oameni panicându-se în urma unor atacuri armate fictive la New York, iar altele arătau scene de război care s-ar desfășura în Gaza sau Myanmar. Ceva mai târziu, au început să apară și clipuri cu femei strangulate – asta deși regulile Sora spun că aplicația nu poate fi folosită pentru a crea conținut violent.

Sora a mai ridicat întrebări și legate de sursa videourilor folosite pentru antrenarea modelului și riscurile de manipulare cu clipuri care, odată ce părăsesc platforma, unde știi că au fost făcute cu AI, pot fi considerate reale.

Noiembrie

Investiții și bule

2025 fost și anul în care s-a investit enorm în AI, cu rezultate îndoielnice. Doar guvernul american a investit 1,3% din PIB în tehnologie, cu marea majoritate a sumei mergând în AI. Uite o mică comparație, care să te ajute să înțelegi proporțiile: proiectul Apollo, prin care americanii au dus un om pe lună a costat 0,8% din PIB, iar Proiectul Manhattan, prin care au construit bombă nucleară, 0,4%. Anul ăsta, Meta, Google, Amazon și Oracle au investit 427 miliarde în noi tehnologii și produse, majoritatea în zona AI.

Aceiași giganți au împrumutat anul ăsta împreună 108 miliarde, de trei ori mai mult decât în media din ultimii nouă ani, conform publicației Bloomberg. Profiturile lor nu se ridică la nivelul acestor sume. OpenAI, de exemplu, a estimat că va opera cu un deficit de 9 miliarde în 2025, iar acest deficit probabil doar va crește în următorii ani, pentru că compania se concentrează pe construcția de centre de date. Și aici încep să apară întrebările legate de o posibilă bulă financiară. Multe întrebări. Mențiunile despre „bula AI” au crescut cu 880% din ultimul trimestru, conform platformei de cercetare și analiză de informații de business AlphaSense, citată de Axios. De asemenea, au fost făcute și comparații cu premisele crizei economice din 2008, precum și cu cele ale altor crize.

„Bula dot com din 2000 ar fi foarte similară cu bula de azi din AI. Investițiile sunt în mare parte speculative”, explică Bogdan Lungu. „Așa cum în 2000, când a explodat bula dot com și au rămas în piață actorii mari pe care îi cunoaștem și astăzi, la fel s-ar putea să se-ntâmple și acum: bula va exploda, dar unele companii sunt prea mari ca să pice.”

Unii analișiti spun că aceste companii își urcă artificial valorea finanțându-se între ele. Uite un exemplu dat de jurnaliștii de la Time: Nvidia a anunțat în septembrie că intenționează să investească 100 de miliarde în OpenAI. O zi mai târziu, OpenAI anunță că Oracle va construi centre de date pentru ei ca parte dintr-un parteneriat în valoare de 300 de miliarde dolari. Oracle va umple acele centre cu chipuri de la Nvidia.

După cum explică un articol The Atlantic, modul în care este finanțat domeniul reflectă faptul că infrastructura necesară pentru instruirea și funcționarea sistemelor de AI este atât de scumpă încât nici măcar cele mai mari companii nu au suficienți bani pentru a o plăti pe toată. Conform articolului, se preconizează că doar cheltuielile pentru centrele de date vor depăși 400 de miliarde de dolari în acest an, o sumă aproximativ echivalentă cu dimensiunea economiei Danemarcei.

Digital Omnibus, încă un subiect de dezbatere

Comisia Europeană a propus simplificarea și relaxarea unei serii de reglementări tehnologice. Ideea este să reducă birocrația, să evite criticile din partea marilor companii de tehnologie și să stimuleze competitivitatea Europei. Pachetul Digital Omnibus, cum este numit, propune, printre altele, modificări ale regulamentului GDPR, astfel încât unele date considerate acum personale să devină accesibile companiilor de tech sau poate fi folosit pentru antrena AI-ul.

„Dacă trece acest Digital Omnibus, cu acele amendamente și relaxări ale legii, o să avem un spațiu mult mai periculos pentru drepturile noastre fundamentale”, explică Lungu. Asta ar putea însemna mai multă supravegherea și monitorizarea și tot felul de abuzuri de putere.

Decembrie

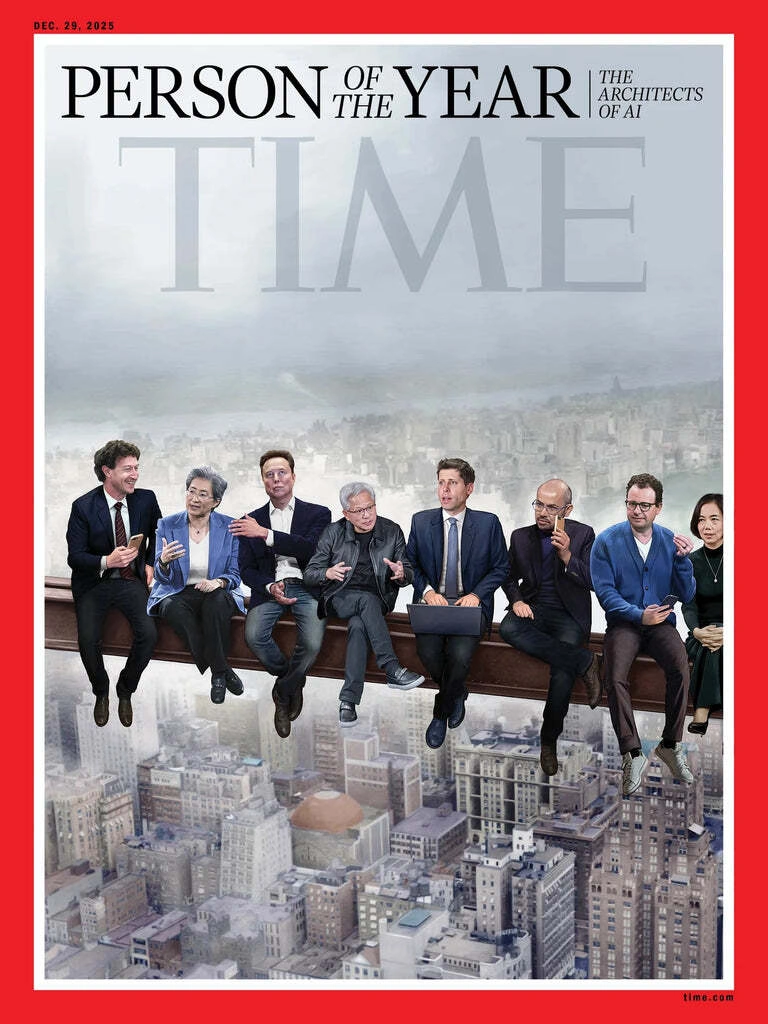

Time încununează AI-ul drept subiectul anului

Arhitecții AI-ului constituie grupul pe care revista a Time l-a desemnat ca „persoana anului”. Pe o bară de oțel suspendată la înălțime peste zgârie-norii din New York stau relaxați Jesen Huang (CEO Nvidia), Mark Zuckerberg, Elon Musk, Sam Altman (CEO OpenAI), Lisa Su (CEO AMD), Masayoshi Son (CEO SoftBank), Demis Hassabis (CEO al diviziei AI DeepMind de la Google), Dario Amodei (CEO Anthropic) și Fei-Fei Li (care deține start-up-ul World Labs). Da, este o trimitere la poza asta celebră cu muncitorii care iau prânzul deasupra New York-ului.

Redacția și-a explicat alegerea astfel: „Acesta a fost anul în care adevăratul potențial al inteligenței artificiale a devenit vizibil și a devenit clar că nu există cale de întoarcere sau de retragere. Oricare ar fi fost întrebarea, AI a fost răspunsul.”

Într-un mod care exemplifică foarte volatilitatea actuală a piaței AI, în ziua în care Time a publicat coperta, acțiunile Oracle s-au prăbușit cu 14%, iar acest lucru a tras în jos toată piața. Lucrurile s-au mai liniștit, dar tot rămânem cu incertitudini pentru viitor.

Merriam-Webster încununează „slop” drept cuvântul anului

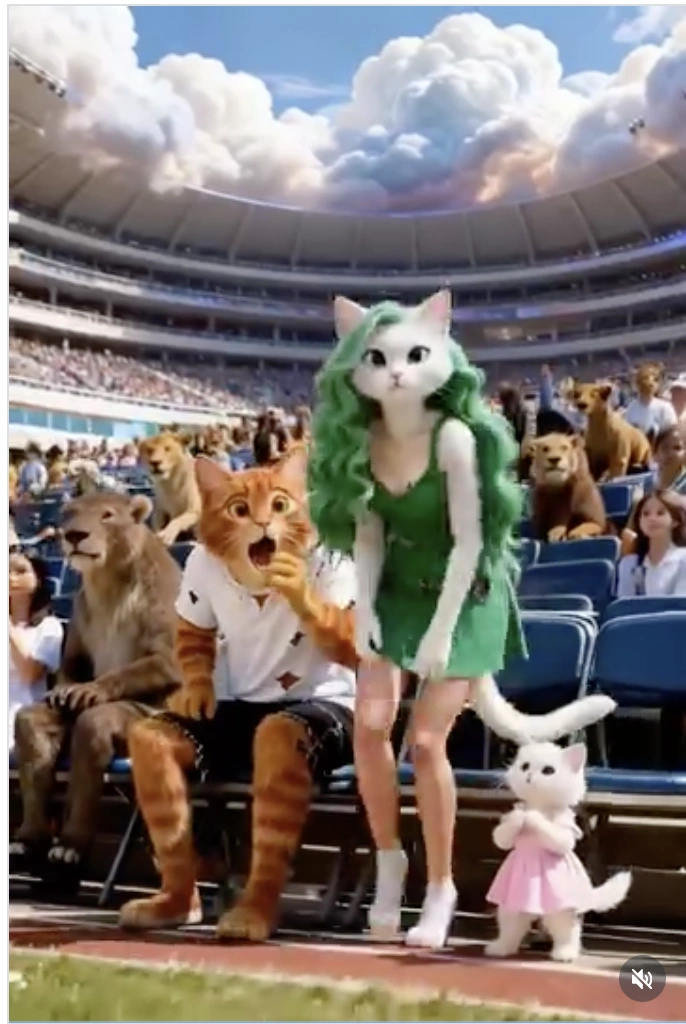

Dacă ai reușit să supraviețuiești anului 2025 fără să știi ce înseamnă slop, felicitări. Slop se referă la „conținut digital de calitate scăzută, produs de obicei în cantitate mare prin intermediul inteligenței artificiale.” Sigur l-ai văzut pe feed-ul de Instagram, Facebook, TikTok sau cam orice rețea socială folosești. De la pozele cu Isus crevete, la fecioara Maria cu cristale vorbindu-ți cu o voce robotică, la AI cu Ronaldo născând copilul lui Messi. Dar mai ales videouri cu pisici antropomorfizate și fără niciun Dumnezeu. Am văzut în propriul feed cum aceste clipuri au ilustrat comploturi tot mai nebunești, au devenit tot mai violente față de pisicile-femei sau pisicile LGBTQ+ sau au înfățișat chestii tot mai absurde – precum acest video cu o pisică care participă la un concurs de bășini. (Trigger warning pentru absolut toate aceste linkuri)

De altfel, canele de YouTube care au prezentat conținut generat de AI au cunoscut creșteri impresionante ale numărului de utilizatori în acest an. Bogdan Lungu explică că asta se întâmplă pentru că conținutul slop nu e gândit să aibă sens sau să transmită vreun mesaj, ci în primul rând să stârnească reacții și să performeze bine după indicatorii din social media.

„E un fel de stupiditate artificială al acestor modele, care nu doar că este promovată de algoritmii de social media, e o relație incestuoasă la mijloc. Social media a creat condițiile ca slop-ul să existe și el reflectă cultura social media to some degree.” Problema, continuă el, este că slop-ul inundă acum platformele până la saturație, făcându-le tot mai neplăcute pentru utilizatorii reali. Și e foarte pesimist că ar putea ieși ceva bun de aici. „Eu văd în mare o devalorizare a muncii intelectuale, a muncii jurnalistice, culturale, o slopificare a internetului. Tot internetul pare făcut cu AI. Un tip de enshittification al spațiului discursiv.”