Din ce în ce mai multe persoane se trezesc că numele și fața lor au fost folosite abuziv în clipuri unde fac reclamă la produse obscure și servicii înșelătoare. Am invitat mai mulți specialiști să ne explice cum funcționează tehnologia care permite aceste manipulări și creează conținut deepfake, care sunt riscurile ei și cum putem depista conținutul sintetic, în contextul unui an cu cele mai multe alegeri din lume, în care riscul de dezinformare este uriaș.

La începutul lui februarie, medicul nutriționist Șerban Damian apărea într-un video pe Facebook, în care făcea reclamă unui remediu minune pentru tensiune arterială. „Dragi români, dacă aveți zgomot în cap și tensiune arterială ridicată, poate fi foarte periculos”, spunea specialistul într-o română puțin stâlcită și nefirească, și îi îndemna pe oameni să cumpere Tonerin, niște pastile naturiste obscure.

Era primul produs la care făcea reclamă Damian. „Eu nu am făcut niciodată reclame la produse. Pot să recomand, dar nu m-aș asocia niciodată cu vreun brand”, explică medicul nutriționist. „Oricum, oamenii urăsc medicii care fac reclame la diverse lucruri, pentru că, în principiu, nu ai avea voie să faci reclamă la nimic”.

Reclama a fost publicată pe Facebook de un cont cu numele Chuyên Tin Sức Khoẻ Trí Não, creat în septembrie 2023, cu poze generice ce par preluate de pe net. Are toate datele unui cont fals. „Nu mai mințiți sataniștilor, că o faceți numai pentru banii excrocilor”, „Parcă spuneați că sunteți medic nutriționist, acum sunteți cardiolog?????”, sunt câteva dintre zecile de comentarii adunate de postare, în mare parte ale oamenilor nervoși pe medicul nutriționist.

Numai că, deși bărbatul din reclamă semăna leit cu Șerban Damian, nu era el în acel video. Era o imagine deepfake. Așa cum o definește un articol publicat în Technology Innovation Review, aceasta este „o imagine hiperrealistă care se folosește de inteligență artificială (IA), pentru a face ca o persoană să spună sau să facă lucruri care nu s-au întâmplat în realitate”. Cineva se folosise de identitatea și de autoritatea sa medicală pentru a face o reclamă înșelătoare.

„Cu ce mă afectează pe mine toată treaba este că sub acel video erau 100 de comentarii în care oamenii mă înjură pe mine”, explică Damian. „Se gândesc: «Uite-l și pe ăsta, la ce face reclamă!» Deci, ei nu știu că e fals clipul, iar mie îmi scade credibilitatea”.

Nu este prima dată când imaginea medicului nutriționist este folosită pentru a promova diverse medicamente. În urmă cu trei ani, Damian a găsit fotografii cu el pe diferite site-uri, unde îndemna oamenii să cumpere medicamente pentru slăbit. După acest episod a mers la poliție.

„Am depus plângere, inițial, la infracțiuni cibernetice, unde mi-au spus că nu au ce să facă. Și m-au trimis să fac plângere la secția de poliție de care aparțin. M-am dus acolo și se uitau ăia la mine ca la extratereștrii. «Ce să facem?», m-au întrebat. Ei se ocupă de furturi de găini, nu de infracțiuni cibernetice”.

Chiar dacă voia să facă plângere, nu știa împotriva cui să o facă. Atunci când a descoperit site-urile care se foloseau de imaginea lui, a început să facă săpături ca să-și dea seama cine era în spatele acestui furt de identitate. Era vorba de o firmă din Anglia, care opera din Bulgaria. Poliția i-a spus că nu prea avea ce să facă în cazul ăsta.

În ultima vreme, au apărut tot mai multe reclame false realizate cu acest tip de tehnologie controversată folosită pentru a crea conținut deepfake. Sebastian Burduja, ministrul Energiei, a fost, la rândul său, implicat într-o reclamă falsă realizată cu ajutorul inteligenței artificiale (IA), în care promova o schemă de investiții false la Enel. A aflat de video de la un prieten, care i-a trimis link-ul pe WhatsApp.

Chiar și premierul Marcel Ciolacu a apărut într-o reclamă similară, în care cineva i-a folosit imaginea fără acordul său, pentru a promova investiții la Hidroelectrica. Mugur Isărescu a apărut și el în mai multe videoclipuri, postate pe Facebook, în care promovează platforme dubioase de investiții. Oficialii Băncii Naționale a României au raportat postarea, însă răspunsul Facebook a fost că acesta „respectă standardele rețelei”.

Victimele acestor furturi de identitate sunt, de obicei, politicieni, influenceri sau persoane publice, a căror imagine este cunoscută și îi poate convinge mai ușor pe oameni, însă oricine se poate trezi într-un clip deepfake. Chiar dacă reclamele cu protagoniști deepfake sunt mai populare în ultima perioadă, această tehnologie e folosită în multe alte domenii, de la pornografie la politică.

În România, parlamentarii ar fi trebuit să dezbată, la jumătatea lunii februarie, un proiect de lege privind utilizarea responsabilă a tehnologiei deepfake. Mai mulți deputați și senatori din partea PSD, PNL, UDMR și neafiliați au propus acest proiect în aprilie 2023, dar dezbaterea că nu s-a mai întâmplat, din cauza criticilor care au apărut pe marginea legii. Proiectul de lege, în forma adoptată de Camera Deputaților, avea lacune, neclarități sau sancțiuni disproporționate, așa cum au explicat reprezentanții mai multor organizații într-o scrisoare deschisă.

Numărul deepfake-urilor a crescut cu 550% din 2019 până în prezent, potrivit unui raport publicat de Home Security Heroes, o companie americană care oferă soluții de securitate. Cu toate astea, încă nu s-au găsit prea multe soluții în ceea ce privește utilizarea abuzivă a acestei tehnologii. China și câteva state din Statele Unite ale Americii (SUA) sunt printre puținele locuri unde deepfake-urile sunt reglementate, încă din 2019.

Recent, în alegerile din Pakistan, un video deepfake cu Imran Khan, fostul premier aflat în închisoare, a ajuns viral. Echipa politicianului a reușit cu ajutorul inteligenței artificiale să încropească un discurs al lui Khan, pe care să-l transmită alegătorilor. Fostul premier fusese condamnat de trei ori în aceeași săptămână, în încercarea de a fi eliminat din cursa electorală. Cu toate acestea, candidații independenți din partea partidului său au câștigat alegerile.

Chiar dacă situația din Pakistan ar putea fi considerată acceptabilă, pentru că acest tip de tehnologie a dat voce unei persoane din partea opoziției, închisă pe nedrept, sunt nenumărate cazurile în care specialiștii își pun întrebări legate de implicațiile etice și consecințele utilizării deepfake-urilor. Mai ales la începutul unui an în care vor avea loc cele mai multe alegeri din lume.

Era deepfake-urilor în politică

Cel mai mare risc pentru 2024, la nivel global, este vremea extremă, urmat de informațiile false create de inteligența artificială. Evaluarea a fost făcută de specialiștii în risc de la World Economic Forum. Pe termen lung, amenințările care pot duce la o criză globală sunt problemele de mediu și dezinformarea.

„Aproape trei miliarde de oameni sunt așteptați la urnele de vot în mai multe țări- Bangladesh, India, Indonezia, Mexic, Pakistan, Marea Britanie și Statele Unite ale Americii în următorii doi ani, iar răspândirea rapidă a dezinformării poate să afecteze legitimitatea guvernelor alese”, prezintă raportul World Economic Forum. „Neliniștea rezultată din aceste lucruri poate să ducă la proteste violente, crime bazate pe ură sau terorism”.

Dacă la început era nevoie de sute de imagini ca să se genereze un video fals, acum există tehnologii care îți cer un singur selfie pentru același rezultat. Site-uri precum DeepFakes Web îți permit să creezi un astfel de video, gratis, în cinci ore. Dacă plătești patru dolari, îl obții într-o oră.

Deepfake-urile au devenit populare prin 2017, pe un thread de Reddit unde au fost postate mai multe clipuri cu celebrități în ipostaze pornografice. Threadul a fost șters la scurt timp, dar imaginile tot au ajuns în canale de 4chan sau pe alte platforme. Articolele de la acea vreme aia dădeau asigurări că încă n-ar trebui să existe îngrijorări legate de folosirea lor în politică.

De altfel, până și în acest moment, majoritatea clipurilor deepfake sunt, de fapt, conținut pornografic. Cercetarea realizată de Home Security Heroes în 2023 arată că, dintr-un total de 95.820 de astfel de clipuri publicate pe internet, 98% sunt deepfake porn. Iar 99% din persoanele targetate de acest tip de conținut sunt femei.

Totuși, era deepfake-urilor în politică pare că vine asupra noastră. Un raport realizat de Centre for Countering Digital Hate (CCDH), o organizație non-profit din Marea Britanie care luptă împotriva extremismului online, arată că dezinformarea care are la bază IA a luat amploare în ultima vreme, în special în cazul deepfake-urilor legate de alegeri. Documentul arată că mențiunile privind IA pe Community Notes, sistemul de fact-checking condus de platforma X, a crescut cu 130% în ultimul an.

Îngrijorările au de-a face cu felul în care acest tip de tehnologie ar putea să erodeze democrația sau să influențeze alegerile prin amplificarea dezinformării și a confuziei între adevăr și fals. Ținând cont că oricine are acces acum la acest tip de tehnologie, lucrurile pot să o ia ușor la vale.

În SUA, materialele deepfake au început să fie folosite încă de anul trecut, mai ales de către politicienii de dreapta. Victime au fost Joe Biden, Hillary Clinton sau chiar jurnaliștii de la CNN. La noi, în Europa, unul dintre cele mai periculoase deepfake-uri a fost cel cu președintele ucrainean Zelenski care îi îndemna pe soldați să predea armele și să renunțe la război.

Deepfake-urile audio, care sunt și mai greu de identificat decât un simplu clip, pot fi un pericol mai mare decât video-urile create cu IA. Asta au experimentat mai mulți votanți din New Hampshire, la începutul lunii februarie, când au primit un apel ciudat de la Joe Biden, care le spunea să nu se prezinte la vot.

Același lucru s-a întâmplat toamna trecută în Slovacia, cu câteva zile înainte de vot. Un audio fals, cu un candidat care vorbea despre creșterea costului berii și falsificarea alegerilor, a fost răspândit pe internet. Partidul lui pro-european a pierdut în fața unuia condus de un politician pro-rus.

În SUA au început să apară propuneri legislative despre cum să fie tratate video-urile și materialele audio sintetice în timpul campaniei electorale. Schimbările au fost introduse în 14 state și au de-a face cu modalitățile de combatere a tehnologiei deepfake în an electoral. Există legi care interzic diseminarea deepfake-urilor înainte cu 60 de zile de alegeri. De asemenea, în șapte state au fost introduse legi care interzic difuzarea tipurilor de media create cu IA înainte de alegeri, dacă nu este specificat felul în care au fost realizate.

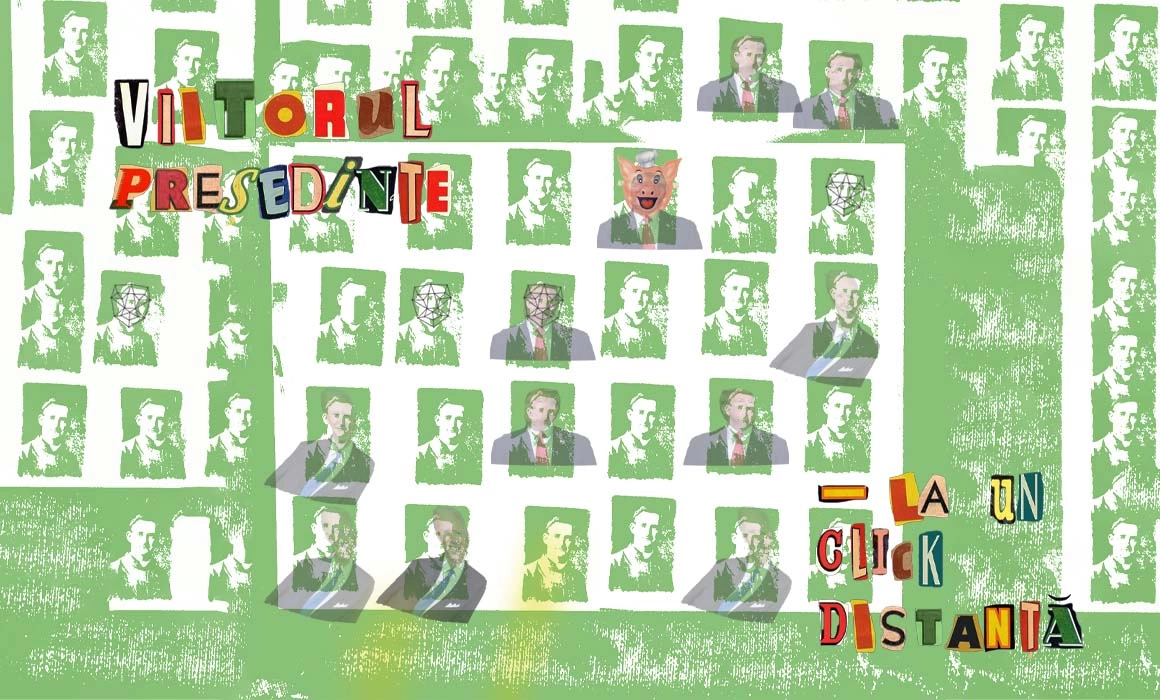

Sebastian Burduja, Ministrul Energiei, crede că vom vedea anul acesta și politicieni români care vor apela la deepfake-uri în campanii.

„Nu este nici etic, nici legal. Și este și foarte periculos”, explică politicianul. Cu toate astea, Burduja este de părere că „nu trebuie să fugim de tehnologiile noi și ar fi cea mai mare greșeală ca, în fața unor asemenea tentative, să respingem orice fel de algoritmi de inteligență artificială, care, până la urmă, ne pot face viața mult mai ușoară”.

Avem mult mai multă tehnologie față de acum cinci ani, de exemplu, dar există și mai multă legislație care o reglementează, explică Alex Ștefănescu, colaboratoarea Asociației pentru Tehnologie și Internet (ApTI). Este vorba despre Digital Services Act (DSA) sau Artificial Intelligence Act (AIA), regulamente europene adoptate recent. „De asemenea, trebuie să ținem cont de faptul că, pe lângă noile tehnologii, avem și o situație ideologică nouă. Pentru că, dincolo de suspecții noștri obișnuiți, avem și o ideologie pe scena politică care este extremistă. Și care are și un limbaj extremist, are și acțiuni extremiste în sfera publică și care se subscrie și unui curent mai larg de extremism, inclusiv din Europa”.

Chiar dacă încă nu am văzut cazuri concrete în care politicienii români să se folosească de deepfake-uri sau de inteligență artificială, sunt deja situații în care aceste tehnologii au ajuns să fie instrumentalizate. La fel cum se întâmpla cu fake news, prin 2016.

Tehnologia deepfake poate să creeze confuzii chiar și atunci când nu e folosită propriu-zis. Un exemplu care ne arată cum poate fi folosit drept scuză deepfake-ul este înregistrarea cu George Simion, publicată de jurnaliștii G4Media. Este vorba despre un audio în care liderul AUR dă undă verde filialelor partidului să primească orice politician din alte formațiuni politice, indiferent „cât de escroci sunt”. Politicianul s-a apărat spunând că nu este vocea lui și că înregistrarea a fost realizată cu ajutorul inteligenței artificiale. Jurnaliștii G4Media au folosit mai multe mecanisme pentru a verifica autenticitatea înregistrării și au ajuns la concluzia că ea este reală.

E nevoie de o lege deepfake?

În urmă cu un an, un grup de senatori și deputați din mai multe partide din România au creat un proiect de lege privind utilizarea deepfake.

Principalele probleme ale proiectului, semnalate recent de mai multe organizații, sunt legate de unele prevederi, cum ar fi sancționarea cu închisoarea de la 6 luni la 2 ani pentru „crearea/realizarea conținutului deepfake”. De asemenea, spun specialiștii, există neclarități care arată că legiuitorul nu a înțeles prea bine fenomenul pe care își dorește să-l reglementeze.

Proiectul de lege ar impune creatorilor de conținut deepfake să semnaleze conținutul printr-un avertisment redat pe 10% din suprafața expunerii sau printr-un mesaj audio care să fie redat la începutul și la sfârșitul materialului. Ceea ce ignoră textul de lege e că acest avertisment poate să fie manipulat astfel încât să nu se vadă sau poate să fie decupat, pur și simplu.

„Din punctul meu de vedere, nu este nevoie de o lege specială pentru deepfake, pentru că este doar un alt tip de înșelătorie,” e de părere Bogdan Manolea, director executiv ApTI. „Chiar dacă ea este în format audio-video, ar trebui să fie reglementată în legislația generală. Dacă apare o altă chestie peste doi ani care se va numi triple fake, facem legislație pentru lucrul ăsta? În acest domeniu se merge pe principiul de neutralitate tehnologică, adică trebuie să ai un text suficient de larg ca să acopere ceea ce astăzi poate să fie infracțiune, dar și ce s-ar putea să fie mâine”.

De asemenea, legea nu ține cont de faptul că instituțiile europene aproape au finalizat Artificial Intelligence Act (AIA), iar de la 17 februarie 2024 a intrat în vigoare Digital Services Act (DSA), care reglementează inclusiv ceea ce fac marile platforme online (VLOPS), un lucru important atunci când vorbim de deepfake-uri.

Scopul AIA este de a garanta că sistemele de IA folosite în cadrul Uniunii Europene sunt sigure și că respectă valorile uniunii. Este prima legislație, la nivel mondial, de acest tip.

AIA ar permite utilizatorilor să depună plângeri în legătură cu sistemele de IA cu grad ridicat de risc, cum ar fi serviciile publice și private esențiale (sănătate, bancare), educație, migrație, justiție, procesele democratice etc. Sistemele trebuie să evalueze și să reducă riscurile, să mențină niște „fișiere de jurnalizare” care permit înregistrarea evenimentelor, să fie transparente și supravegheate de oameni. Actul va extinde și lista aplicațiilor IA interzise în UE care prezintă un risc pentru drepturile fundamentale, printre altele. De asemenea, stabilește amenzi de 35 de milioane de euro sau 7% din cifra de afaceri pentru companiile de tehnologie care au comis o abatere de la act.

Sebastian Burduja a raportat către Meta video-ul în care apărea, fără voia lui, promovând servicii false de investiții. Nu s-a întâmplat nimic. La fel a făcut și nutriționistul Șerban Damian, a cărui imagine a fost falsificată în reclama la suplimente alimentare. I s-a răspuns că video-ul este real, așa că platforma nu poate să-l șteargă. Influencerul Selly, la fel ca Damian sau Burduja, a apărut într-un video deepfake în care promova un joc de pariuri. Chiar dacă a raportat clipul către Facebook, el tot apare pe internet.

„Pe de-o parte, în treaba asta, păgubiții sunt cei care cumpără produsul respectiv pentru că achiziționează, de fapt, apă de ploaie și iluzii”, explică Damian. „Pe de-altă parte, păgubitul este persoana în cauză. Mi se deformează imaginea dacă văd oamenii că fac reclame la o prostie care nu funcționează”.

Nu este prima dată când marile companii nu răspund adecvat la raportările făcute de către utilizatori. Este una dintre problemele foarte mari pe care le au platforme gigant, precum Meta, X, YouTube, TikTok sau Google.

Digital Services Act, recent adoptat în UE, își propune să rezolve această problemă prin intermediul raporturilor de transparență prezentate către Comisia Europeană de către marile companii. Raportul trebuie prezentat o dată la șase luni, iar acolo se observă, printre altele, câți moderatori de conținut au angajat platformele pentru fiecare limbă. Prin aceste rapoarte se urmărește o mai bună înțelegere a contextului în care se produc deepfake-urile, dar și o reacție mai informată din partea platformelor la sesizări.

Situația nu e prea roz. Google are cei mai mulți moderatori pentru limba română: 2.253, urmat de TikTok – 167. Meta are 135, în timp ce LinkedIn nu are niciunul, iar X nici măcar nu menționează limba română în raportul de transparență. Româna nu e singura limbă pe care au omis-o cei de la compania condusă de Elon Musk, având în vedere că au prezentat un raport privind moderatorii de conținut doar pentru 13 limbi.

Chiar dacă ar exista mai mulți moderatori, tot nu s-ar schimba prea multe dacă persoanele respective n-ar cunoaște și contextul în care apar aceste deepfake-uri. „Un sistem automatizat sau cineva care nu este familiarizat cu limba română nu o să vadă ceva în neregulă cu materialul respectiv,” explică Bogdan Manolea. „Dacă știi contextul, de exemplu, înțelegi că Mugur Isărescu este guvernatorul BNR și că nu are voie să facă reclamă la investiții. (...) Ar trebui să îți dai seama că pur și simplu este imposibil ca aceea să fie o reclamă adevărată, sau un videoclip adevărat”.

Dacă până și persoanelor publice le este greu să dovedească în fața platformelor că au fost victimele noilor tehnologii folosite în scopuri manipulatoare, lucrurile devin din ce în ce mai greu de probat în cazul oamenilor obișnuiți. „Este un lanț al slăbiciunilor”, crede Alex Ștefănescu, colaboratoarea ApTI. „În zona asta nu ne poate ajuta doar legea. Avem nevoie și de o conștiință socială”.

De unde ar trebui să vină reparațiile?

Încă e neclar ce poate să facă victima unui deepfake ca să-l vadă eliminat sau ca să obțină despăgubiri.

„Trebuie să-ți dai seama cât de eficiente ar putea să fie instrumentele procedurale pe care tu le folosești”, explică Bogdan Manolea. „Dacă te gândești, de exemplu, să faci o plângere penală, trebuie să fii sigur că ai suficiente probe sau că polițiștii sau procurori pot să demonstreze probele respective”.

Altfel, e posibil să ajungi cu un dosar care nu va fi soluționat niciodată. „Digital Services Act propune niște sisteme alternative de rezolvare a disputelor în afara instanțelor, care momentan nu există, dar care ar trebui să fie create”, continuă directorul executiv ApTI. „Acolo ar putea fi soluțiile, nu neapărat în instanțe, care sunt deja supraîncărcate”.

Persoanele juridice pot solicita Autorității Naționale pentru Administrare și Reglementare în Comunicații (ANCOM) certificarea ca organism de soluționare extrajudiciară a litigiilor inițiate împotriva furnizorilor de platforme online. Organismele certificate au obligația de a transmite ANCOM rapoarte privind numărul litigiilor rezolvate, durata de soluționare a acestora și problemele pe care le-au întâmpinat în rezolvarea lor. Nu este primul mecanism de acest tip. De exemplu, „SAL-Fin (Entitatea de Soluționare Alternativă a Litigiilor în Domeniul Financiar Non-bancar) se ocupă de soluționarea litigiilor care apar între consumatori și entitățile care funcționează pe piața asigurărilor, pe piața de capital sau pe piața pensiilor private”, potrivit descrierii de pe site-ul lor.

Toate aceste lucruri se aplică în cazul deepfake-urilor politice sau fraudelor de tipul celor în care au fost implicați Burduja sau Damian. Când vorbim de lucruri mai sensibile, precum deepfake în pornografie, când fața cuiva este suprapusă altor corpuri într-un video cu conținut sexual explicit, acolo lucrurile se complică și mai tare. Chiar dacă persoana care a făcut acel video ajunge în închisoare, asta nu repară răul făcut victimelor.

„Încălcarea consimțământului s-a făcut, [când vorbim despre deepfake în pornografie, n.r.] indiferent că tu spui cu ce soft ai făcut sau nu [materialul deepfake, n.r.], potrivit legii. Și consimțământul ăla nu se repară făcând pe cineva să plătească bani sau făcându-l să facă pușcărie”, explică Alex Ștefănescu. „Repararea vine în partea cealaltă, de care ne e mult mai greu să discutăm. Vine din educație, din cum vorbim despre lucrurile astea și cum tratăm persoanele pe mai departe”.

Bineînțeles, nu orice deepfake este folosit în scopuri rele. Există și beneficii la acest tip de tehnologie.

Poate ajuta în domenii precum medicina, unde ar putea să permită persoanelor cu Alzheimer să interacționeze cu o versiune de-a lor mai tânără pe care e posibil să și-o amintească. Sau oferă posibilitatea unei persoane trans să se vizualizeze așa cum și-ar dori. Mai sunt folosite și-n filme, la actorii care și-au pierdut vocea. Fără aceste video-uri n-am fi putut să-i vedem la un loc pe Keanu Reeves și Timothée Chalamet, sărbătorind un Crăciun în stil sovietic. Sau pe Snoop Dogg care dă-n Tarot, sau alte combinații fanteziste.

Cu toate acestea, mijloacele prin care sunt create aceste deepfake-uri, chiar și dacă au intenții bune, încă sunt criticabile, explică Alex Ștefănescu. „Indiferent cum e făcută chestia asta, din punctul meu personal de vedere, este o exploatare a muncii și nu are cum să fie etică. Nu pot să justific să-mi însușesc munca a nenumărați artiști de dragul de a crea, oricum, o ciorbă reîncălzită a artei lor”.

Exploatarea muncii care stă la baza antrenării IA este una dintre criticile cele mai mari aduse acestui tip de tehnologie, alături de folosirea de date de la oameni care nu și-au dat consimțământul.

Adevărul în vremea inteligenței artificiale

O altă întrebare pe care și-o pun cercetătorii, când vine vorba de deepfake, are legătură cu felul în care această tehnologie va schimba modul în care percepem adevărul, deja erodat masiv de fake news și propagandă amplificate de canalele digitale.

„Aceasta e o provocare de moment a transformării culturale, merită să ne gândim exact la posibilitatea de a migra spre alte surse ale cunoașterii”, explică Constantin Vică, cercetător în etica noilor tehnologii la Facultatea de Filosofie a Universității din București. „Una ar fi să ne asigurăm că știm cine vorbește pentru că împărțim un spațiu apropiat cu acea persoană. Alta ar fi să nu mai credem nimic, nici măcar ceea ce vine prin viu grai, până nu știm că putem verifica oricând cine vorbește.”

Pentru că nu vom mai avea capacitatea de a verifica mereu o corespondență cu faptele, continuă Vică, merită să ne întrebăm dacă vor deveni mediile de comunicare mai personale, încercând să transmitem mai mult celor care ne recunosc și pe care îi recunoaștem așa cum sunt?

„Obsesia pentru autentic și autenticitate s-ar putea să ne păcălească și să vedem astfel de imagini, video-uri sau avatare în jocuri ca fiind false. Contrafăcute. Dar ele sunt, totuși, transportatoare de semnificație care participă la experiența noastră în lume, așa cum niște adidași luați de la un băiat pe OLX ți se așază în picioare și mergi, chiar dacă nu vor fi la fel de buni într-un final”.

Realul nu mai contează

Cum recunoști un deepfake, mai ales acum când tehnologia devine din ce în ce mai sofisticată? Cel mai ușor, atunci când nu ești sigur dacă ceea ce apare într-un video e real sau nu, este să fii atent la față.

„În primul rând la gură, care poate să fie mai pixelată decât restul”, explică Alex Lungu, artist și expert multimedia. „Asta pentru că AI-ul care face asta e antrenat pe VoxCeleb, un database de celebrități care vorbesc, iar imaginile alea sunt micuțe”.

Apoi, ar mai fi de luat în seamă și felul în care se mișcă gura. „Uneori, capul se mișcă, iar gura încearcă să se miște odată cu capul. Dar, alteori, face greșeli și se duce mai sus sau mai jos de nas. Dacă ai folosit deepfakes mai vechi, care au acces la mai multe resurse, ele vor ieși foarte bine”, continuă Lungu. „Însă, uneori, fața o să aibă mai multe detalii decât filmarea. Iar asta ar putea să dea în vileag”.

Alex Lungu a creat instalația „Look out! Videos a year from now on”, în care o replică AI îți povestește despre deepfake și posibilitățile nelimitate ale acestei tehnologii. Începe cu poze drăguțe, la prima vedere, care n-au nicio legătură cu privitorul, iar pe parcurs devine din ce în ce mai personală, folosindu-se de poze cu cei care vizitează expoziția și video-uri înregistrate de dinainte, pentru a spune o poveste personală.

Poți să-ți dai seama dacă ai de-a face cu un deepfake și atunci când sesizezi mai multe nuanțe de negru în zona feței, nuanțe pe care restul materialului video nu le are. Alteori, dacă cel care realizează video-ul schimbă doar ceea ce se aude, sunt importante gesturile. „Poate nu se pupă la fix cu ce zice omul și atunci e posibil să fie un video fals”, explică artistul.

Pe lângă toate aceste detalii, un alt aspect în recunoașterea unui video fals ține de alfabetizarea digitală (media literacy). Iar un concept important, când vine vorba de educație media, este contextul, explică Bianca Rus, manager de proiecte în cadrul Centrului de Jurnalism Independent (CJI).

În martie 2023, o imagine cu papa Francisc care purta o jachetă lungă, albă, inspirată după Balenciaga, a devenit virală. La fel ca în cazul imaginilor cu Donald Trump care este arestat, multă lume a presupus că imaginea este reală, alții s-au prins că e falsă. Bianca Rus povestește cum, la un atelier organizat e CJI, au discutat cu elevii despre imaginea cu Papa.

„Și-au pus întrebări, dar un singur copil a venit și a întrebat «Păi cum să poarte Papa Balenciaga? Balenciaga a fost în mare controversă, că aveau mesaje subliminale pentru pedofili». Acestea sunt întrebările de context care îți arată că știi să recunoști”.

Întrebările legate de context sunt în strânsă legătură cu nivelul de informare și consumul de media al oamenilor. Odată ce ți-ai antrenat acest simț, devine aproape un obicei.

Ca să combați fenomenul deepfake sau cel al imaginilor create cu un tip de IA, nu mai e suficient să aplici principiul din jurnalism cu „verifică informația din trei surse”. Pentru că e nevoie să faci legături între lucrurile pe care le citești, iar pentru asta e nevoie să știi contextul mai mare.

Oricum, nu funcționa prea bine nici vechea regulă a verificării. Românii sunt printre cetățenii din Uniunea Europeană care verifică cel mai puțin informațiile care le găsesc pe internet, potrivit datelor publicate de Eurostat în 2021. Suntem pe penultimul loc la capitolul ăsta. Doar 12% dintre români trec prin acest proces de verificare, comparativ cu media europeană de 23%.

Tocmai de aceea, specialiștii precum cei de la CJI încearcă să promoveze importanța educației media, adaptată la evoluțiile tehnologice, care să-ți permită să analizezi critic lucrurile pe care le vezi pe ecran.